Cómo usar Stable Diffusion XL en cualquier ordenador para crear imágenes por inteligencia artificial

Vamos a explicarte cómo usar gratis Stable Diffusion XL en cualquier ordenador sin importar su potencia. Es la nueva versión de la inteligencia artificial para crear imágenes. Stable Diffusion fue el primer gran modelo de generación de imágenes mediante IA a partir de texto, y aunque en los últimos meses ha habido otros como Midjourney y Dall-E que se han ganado mucha fama, los creadores de este primero han lanzado una nueva versión muy mejorada.

Estamos hablando de una de las mejores alternativas a Midjourney, que es de código abierto para que cualquiera pueda utilizarla gratis. Este nuevo modelo ofrece mucha más calidad de imagen y mejor resolución, además de otras mejoras en la fase de entrenamiento. También tiene más inteligente para entender los contextos de los prompts.

Para poder usar este modelo en un ordenador sin una poderosa GPU, vamos a utilizar el servicio Google Colab. Se trata de un servicio donde Google te presta hardware de forma remota, para que puedas ejecutar código en él. Lo bueno es que no tendrás límites de potencia para usar Stable Diffusion XL, y lo malo es que cada vez que quieras usarlo tendrás que repetir el proceso que te vamos a decir.

Stable Diffusion XL online en cualquier PC

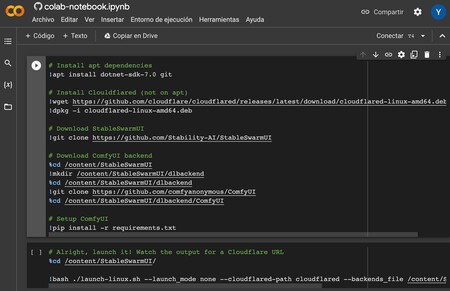

Si no tienes un ordenador potente, podrás usar Stable Diffusion XL en cualquiera mediante ESTE ENLACE de Google Colab. Con él irás a una ficha donde ya está el código para instalar y ejecutar Stable Diffusion XL.

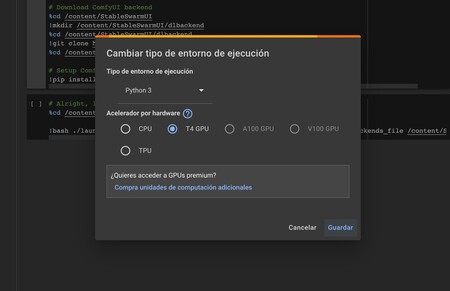

Una vez estés dentro de Colab, lo primero que tienes que hacer es pulsar en Entorno de ejecución, y pulsa en Cambiar tipo de entorno de ejecución. En la ventana que se abre, asegúrate de tener seleccionada la opción GPU en Acelerador por hardware. Así, te asegurarás de ejecutar esta IA de forma correcta.

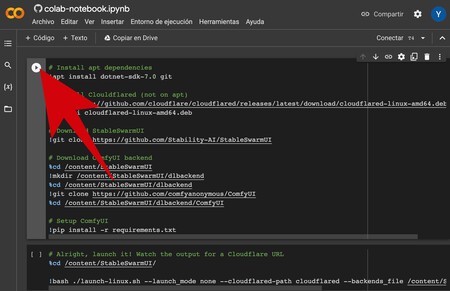

Una vez lo hayas hecho, tienes que pulsar en el botón de ejecución de la primera celda de datos. Verás que el contenido de la página está dividido en dos grupos, pues pulsa en el botón con el símbolo de reproducción que hay a la izquierda del primero.

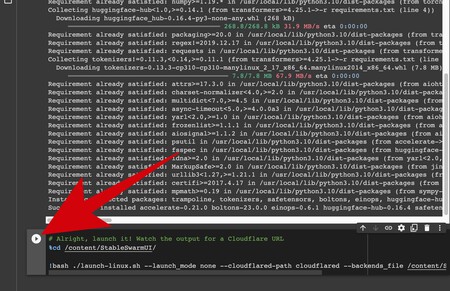

Esto ejecutará los códigos para instalar las dependencias de Stable Diffusion en la máquina virtual. Cuando pulses en la opción, te saldrá una advertencia diciéndote que el código no lo ha creado Google, y pulsa en la opción de ejecutar de todos modos. Verás que empiezan a salir letras debajo mientras realiza la tarea, y tienes que esperar a que se termine de instalar. Puede tardar unos minutos.

Una vez se termine de ejecutar la primera, tienes que ejecutar la segunda celda. Para eso, pasa el ratón sobre ella hasta que aparezca el botón de ejecución, y pulsa sobre él.

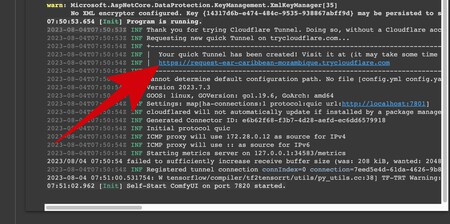

Esta celda no se detendrá, seguirá ejecutando la aplicación, y cuando ya no se mueva busca el enlace para acceder a la interfaz en el texto, que te pondrá Your quick Tunnel has been created! Visit it at.

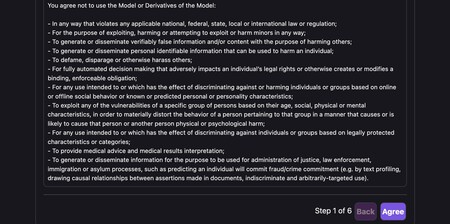

Al pulsar sobre el enlace, se abrirá una página para ir configurando el modelo. Primero te aparecerán los textos de la licencia, con el nombre Stable Diffusion Model License. Ve abajo del todo y pulsa en Agree.

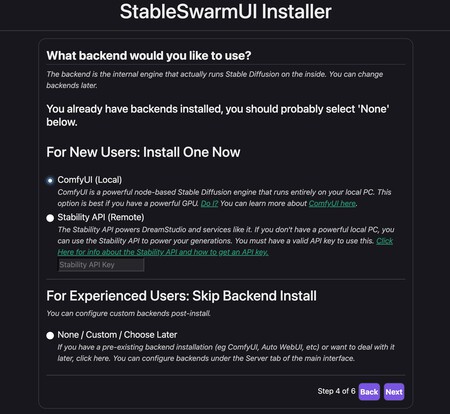

Ahora tendrás que ir configurando el modelo en varias páginas. Primero tendrás que elegir el tema de colores, luego tendrás que indicar que solo lo vas a usar tú en tu PC con la opción Just Yourself On This PC. Luego tendrás que elegir la forma en la que se ejecutará Stable Diffusion XL, y en ella tienes que elegir la opción ComfyUI.

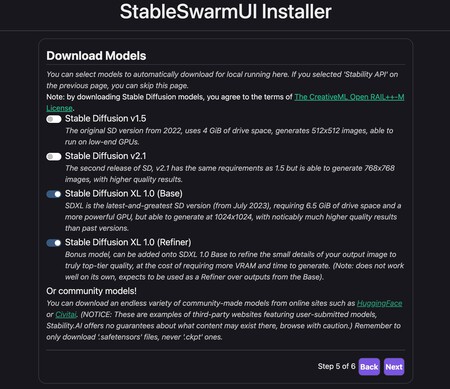

En el siguiente paso, tienes que elegir qué modelos quieres descargar. Puedes elegirlos todos si quieres, pero lo más importante es activar las dos opciones de Stable Diffusion XL, la base del modelo y la refinada. En la siguiente y última página verás el resumen, y tienes que pulsar en Yes, I’m sure para iniciar la instalación.

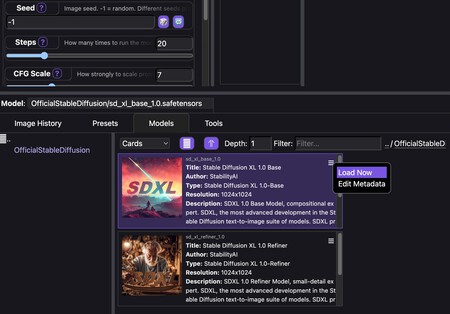

Cuando se termine la instalación, entrarás automáticamente a la página de Stable Diffusion XL. Antes de empezar a crear imágenes, abajo pulsa en la pestaña Models. En ella, pulsa en los dos puntos que aparecen en la columna de la izquierda, y elige el modelo OficialStableDiffusion. Aquí dentro, selecciona el modelo Stable Diffusion XL 1.0 Base.

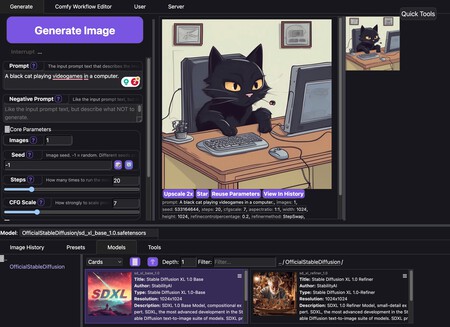

Una vez elegido el modelo, simplemente tienes que escribir la descripción de lo que quieres en el cuadro de Prompt y pulsar en Generate Image para crear tu imagen a partir de tu descripción. El texto tiene que estar en inglés, y la generación de las imágenes a partir de cada descripción tardará unos segundos. También puedes poner Negative Prompts para añadir elementos que no quieres que aparezcan.

Y a partir de aquí, en la página también tienes otros ajustes para controlar al máximo la creación de la imagen, e incluso para decidir cuántas imágenes creas cada vez. Si también has instalado el modelo Refiner, en las opciones vas a poder activar la opción Refiner y cargar ahí ese modelo. Así, se mejorará todavía más la calidad.

Aquí, debes tener en cuenta que este modo no es infalible, y a veces puede fallar la aplicación, momento en el que puedes pulsar F5 para volver a cargar la página, o detener y volver a cargar el segundo paso de Google Colab.

En Xataka Basics | 18 extensiones basadas en inteligencia artificial y ChatGPT para Chrome, Edge, Firefox o Safari

–

La noticia

Cómo usar Stable Diffusion XL en cualquier ordenador para crear imágenes por inteligencia artificial

fue publicada originalmente en

Xataka

por

Yúbal Fernández

.

This content was originally published here.